L'IA pour lutter contre les fraudes à la Sécurité sociale ?

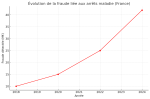

Les fraudes à la Sécurité sociale coûtent plusieurs centaines de millions d'euros chaque année. Urssaf, CNAF et Assurance Maladie s'équipent progressivement d'outils d'intelligence artificielle pour mieux cibler les contrôles et détecter les abus, notamment les faux arrêts maladie. Mais ces technologies posent aussi des questions éthiques.

Des algorithmes déjà utilisés dans le social

Depuis plusieurs années, la CNAF (allocations familiales) et l'Urssaf utilisent des algorithmes de scoring pour cibler les contrôles. Ces outils permettent de détecter des anomalies dans les déclarations et d'optimiser les vérifications sur le terrain. L'Urssaf affirme que ces technologies ont permis d'augmenter significativement les redressements pour travail dissimulé.

Vers une IA pour traquer les faux arrêts maladie

L'Assurance Maladie teste actuellement des partenariats avec plusieurs start-ups spécialisées dans l'IA. L'objectif : analyser les dossiers d'arrêts maladie et repérer les schémas suspects. Ces modèles pourraient attribuer un score de risque et déclencher un contrôle avant versement des indemnités.

Quels modèles d'IA sont envisagés ?

Les solutions étudiées reposent sur des modèles de machine learning supervisé et de détection d'anomalies. L'IA apprend à partir de milliers de dossiers passés pour identifier les situations atypiques : arrêts répétés, incohérences médicales ou comportements inhabituels d'un employeur.

Des enjeux éthiques et juridiques

L'utilisation de l'IA dans le contrôle social suscite des critiques. Des associations comme Amnesty International et La Quadrature du Net alertent sur les risques de discrimination et de manque de transparence. En Europe, l'AI Act encadre strictement les décisions automatisées qui ont un impact sur les droits individuels.

Sources

- TF1 Info – L'IA au service de l'Urssaf

Reportage expliquant comment l'IA aide l'Urssaf à cibler les contrôles du travail dissimulé. - Le Dauphiné – L'Assurance Maladie veut renforcer sa lutte contre la fraude

Article détaillant les nouveaux outils numériques et partenariats pour détecter les fraudes aux arrêts maladie. - Amnesty – Notation algorithmique et discriminations

Analyse critique des systèmes de scoring algorithmique utilisés par la Sécurité sociale. - Vie publique – Fraude sociale : des pertes importantes sur les cotisations sociales

Source pour les chiffres récents de la fraude sociale et son évolution.

L'IA est-elle déjà utilisée pour vérifier les arrêts maladie ?

Pas encore à grande échelle. L'Assurance Maladie teste des outils de scoring, mais ils ne sont pas encore déployés nationalement.

Quels organismes utilisent déjà l'IA contre la fraude sociale ?

L'Urssaf et la CNAF utilisent déjà des algorithmes de scoring pour cibler les contrôles et détecter des anomalies dans les déclarations.

Quels sont les risques liés à l'utilisation de l'IA contre la fraude fiscale?

Les critiques portent sur la transparence, le risque de biais discriminatoire et le respect du RGPD. L'AI Act européen impose un contrôle humain pour les décisions ayant un fort impact.